C’est en 1994 que le centre de Recherche Inria Grenoble décide de s’implanter au cœur de la technopole inovallée, sur Montbonnot, sous l’impulsion de Jean-Pierre Verjus. « Nous aurions évidemment pu nous installer sur le campus de Saint Martin d’Hères, mais il est toujours plus facile de travailler avec ses cousins chercheurs que de nouer des partenariats avec le monde industriel, ce qui était et demeure l’une des ambitions d’Inria. Je suis persuadé que la proximité géographique est une des clés de la fertilisation croisée qui fait le succès de l’écosystème grenoblois d’innovation. Et c’est la raison pour laquelle j’ai milité à l’époque pour implanter le centre Inria de Grenoble Alpes au cœur de la technopole et des entreprises », se souvient Jean-Pierre Verjus.

Cette implantation a d’ailleurs marqué une étape clé dans le développement d’inovallée. Après Schneider Electric et Orange Labs (le C.N.E.T à l’époque), Inria a ainsi été la troisième locomotive qui a accéléré l’essor de la troisième tranche bonimontaine de la technopole. Inria Grenoble-Rhône-Alpes, implanté sur la technopole, mais aussi sur le campus de l’université Grenoble-Alpes, à Minatec, et à Lyon (ENS Lyon et campus universitaire de la Doua), ce sont aujourd’hui plus de 35 équipes projet et plus de 650 scientifiques et personnels d’appui à la recherche et l’innovation qui travaillent autour de 4 grands domaines scientifiques:

- Systèmes informatiques distribués: calcul haute performance, informatique en nuage et réseaux sans fil

- Fiabilité et performance du logiciel: méthodes formelles pour la conception et la vérification de systèmes concurrents, embarqués et distribués, compilation et synthèse de haut niveau

- Perception et interaction avec le monde réel et environnements virtuels: informatique graphique, apprentissage machine, reconnaissance d’images, robotique et véhicules autonomes

- Modélisation, simulation et contrôle de phénomènes multi-échelles et multi-dimensionnels: systèmes dynamiques non linéaires et en graphes, statistiques, modèles et méthodes numériques pour la biologie, la médecine, l’océan et l’atmosphère

avec un accent particulier mis sur la science des données, la modélisation de l’environnement, la fiabilité technique, environnementale et éthique du logiciel, et enfin l’informatique quantique.

Des chercheurs au cœur des entreprises et… des collaborations à la clé avec des acteurs industriels comme Atos, Orange, Naverlabs!

En 30 ans, cette implantation au cœur des entreprises a permis non seulement la naissance de plus de 25 startups, mais aussi et surtout a facilité les projets collaboratifs avec des entreprises du territoire. Un partenariat dynamique s’est par ailleurs développé depuis plusieurs années entre Le Tarmac Inovallée et Inria (Service Innovation, Atelier d’Innovation), qui co-organisent des événements dédiés innovation et soutiennent la mise en place de projets de R&D entre des laboratoires et des startups, en cohérence avec la politique de création d’entreprises deeptech d’Inria (Inria StartupStudio).

Pour preuve, à ce jour, une thèse conjointe est portée par Inria et Orange dans le cadre de l’institut MIAI (Multidisciplinary Intitute Artificial Intelligence) sur l’apprentissage fédéré (dans le cadre de la chaire « edge intelligence » portée par Denis Trystram). Une des deux équipes communes avec Orange en cours de création s’installera sur la technopole.

Plusieurs projets de recherche partenariale relient par ailleurs des équipes-projet communes Inria à NaverLabs.

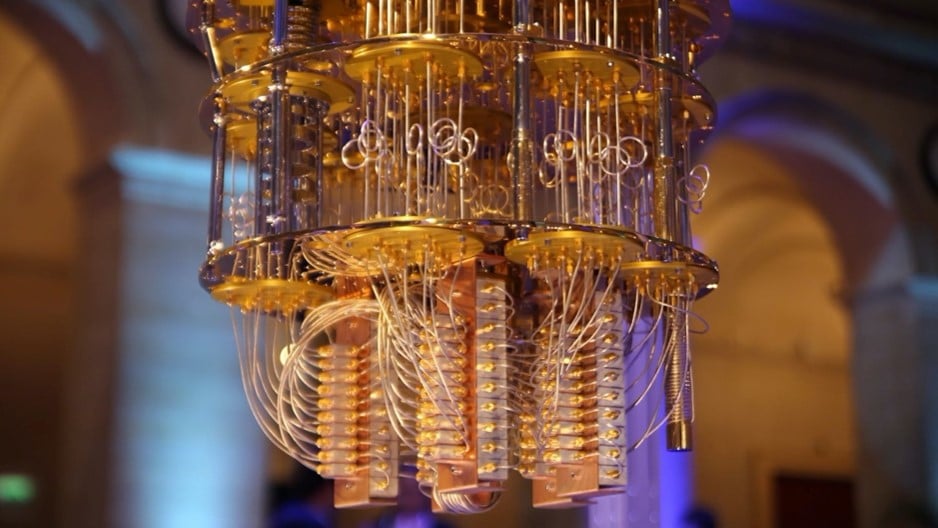

Inria en route pour la révolution quantique

(source : https://www.inria.fr/fr/informatique-quantique-revolution)

Né dans les années quatre-vingts après que les scientifiques ont commencé à envisager d’utiliser les propriétés mécaniques quantiques pour résoudre des calculs difficiles, le concept d’informatique quantique attise, depuis plusieurs années déjà, l’intérêt de tous.

Les ordinateurs classiques sont programmés avec des bits comme unités de données. Chaque bit peut stocker un 0 ou un 1. Pourtant, ces ordinateurs sont mis face à leurs propres limites lorsqu’ils se retrouvent confrontés à un problème de variables multiples. Dans ce cas, les ordinateurs doivent effectuer un nouveau calcul chaque fois qu’une variable est modifiée. Chaque calcul est un chemin unique vers un résultat unique.

L’ordinateur quantique se base lui sur deux concepts de la physique quantique :

- Le concept de la superposition d’états. La superposition est la capacité contre-intuitive d’un objet quantique, comme un électron, à exister simultanément dans plusieurs « états » différents. Elle est littéralement dans ces différents états à la fois : à la fois dans un état et dans autre, sans faire une moyenne des deux. Une mesure détruira cette superposition, et ce n’est qu’alors que l’on pourra dire qu’il est dans l’état inférieur ou supérieur.

- La mesure dans la mécanique quantique. Il n’est pas possible de mesurer deux choses dont la connaissance simultanée est impossible : la position et la vitesse d’une molécule, par exemple. Il est ainsi important de savoir ce que l’on mesure, sinon on perturbe l’état. C’est ce qu’on appelle l’action retour de la mesure : si on mesure l’état quantique on peut de manière irréversible changer son état.

En raison des lois de la mécanique quantique, l’ordinateur quantique utilise des qubits, qui peuvent représenter une combinaison de 0 et de 1 en même temps, selon le principe de superposition. Chaque qubit existe ainsi en multiple états de 0 et 1, simultanément. L’ordinateur quantique va ainsi exploiter l’intrication entre les qubits et les probabilités associées aux superpositions pour effectuer une série d’opérations, de telle sorte que certaines probabilités soient augmentées (c’est-à-dire celles des bonnes réponses) et d’autres diminuées, voire nulles (c’est-à-dire celles des mauvaises réponses).

C’est cette possibilité d’emprunter un nombre gigantesque de chemins qui rend les ordinateurs quantiques bien plus rapides que les ordinateurs classiques.

Grâce à cela, l’ordinateur quantique devrait ainsi avoir le potentiel de résoudre certains types de problèmes, aujourd’hui insolubles. Parmi ceux-ci, citons par exemple la simulation de l’enzyme nitrogénase, qui permettrait de contourner le procédé Haber-Bosch (ce procédé, optimisé pour son époque – tout début du XXe siècle – conduit pourtant à consommer 3 à 5 % de l’ensemble du gaz naturel produit, et environ 1 à 2 % des réserves mondiales en énergie, pour la synthèse de l’ammoniac). Un ordinateur quantique pourrait ainsi permettre de comprendre comment cette enzyme fonctionne, pour pouvoir catalyser à température ambiante et fabriquer des engrais azotés, sans chauffer.

Bien qu’aucun ordinateur quantique ne soit encore assez sophistiqué pour effectuer ces calculs, les gouvernements, les géants de la technologie et les investisseurs, eux, se préparent déjà à cette révolution en construction. Une véritable course à l’ordinateur quantique, largement motivée par les bouleversements technologiques que cette machine devrait apporter. Et pour cause : la nation qui prendra la tête de l’informatique quantique devrait jouer un rôle de premier plan à l’avenir.

Mais avant de pouvoir profiter du potentiel de l’ordinateur quantique, de nombreux verrous doivent encore être levés afin que celui-ci puisse déjà voir le jour.

La décohérence en est l’obstacle majeur : l’ordinateur quantique, pour calculer de manière bien plus rapide et efficace qu’un ordinateur classique, va utiliser la superposition et l’intrication d’états qui sont beaucoup plus sensibles à l’environnement que les états classiques. Plus on va ajouter de qubits à un système, plus la quantité d’opérations parallèles va être augmentée et, par conséquence, la puissance de calcul aussi. On estime ainsi que près de 300 qubits parfaitement enchevêtrés en superposition pourraient cartographier toutes les informations de l’univers à partir du Big Bang.

Pourtant, lorsque l’environnement interagit avec les qubits (ce qui est nécessaire pour que la mesure quantique fonctionne), celui-ci va changer de manière incontrôlable leurs états quantiques. C’est ce qu’on appelle la décohérence. Celle-ci peut provenir de nombreux aspects de l’environnement : modifications des champs magnétiques et électriques, rayonnement d’objets chauds à proximité ou interactions non contrôlées entre les qubits.

La décohérence affecte l’état de superposition et perturbe le traitement quantique de l’information. Cela conduit à des erreurs dans les systèmes de calcul quantique. Alors qu’un ordinateur classique se révèle très fiable, un ordinateur quantique ferait une erreur sur 1 000 opérations (pour les meilleurs d’entre eux). Les codes codes correcteurs d’erreurs font partie des dispositifs considérés pour parvenir à des ordinateurs quantiques fiables. Ils ont été très largement étudiés et appliqués en communication et dans les ordinateurs classiques, où ils permettent de stocker l’information avec une certaine redondance pour corriger automatiquement certaines erreurs se manifestant dans des dispositifs de stockage, de transmission ou de traitement de l’information. Malheureusement, des résultats classiques en théorie de l’information comme le théorème de Shannon sur lesquels s’appuient ces codes, ne tiennent plus dans le cas quantique.

« De mon point de vue, c’est presque un miracle que la théorie de Shannon fonctionne, et que l’on puisse comprendre exactement les codes correcteurs à utiliser, déclare Omar Fawzi, directeur de recherche INRIA à Lyon et lauréat d’une bourse ERC sur la théorie de l’information quantique,. Mais dans le cas quantique, le miracle ne se produit pas. Or c’est encore plus important car il y a encore plus de bruit. »

La France parmi les leaders européens du quantique

(source : https://www.inria.fr/fr/acteurs-informatique-quantique)

Si elle ne peut pas prétendre avoir autant de force de frappe que les États-Unis et la Chine, la France peut tout de même se targuer d’être l’un des leaders européens dans l’informatique quantique.

En avril 2019, le gouvernement confiait ainsi à la députée LREM Paula Forteza, à l’ex-PDG de Safran Jean-Paul Herteman, et au directeur de recherche du CNRS Iordanis Kerenidis une mission relative aux technologies quantiques. Quelques mois plus tard, en janvier 2020, le rapport Quantique : le virage technologique que la France ne ratera pas était remis au gouvernement. Celui-ci, qui contient une liste de propositions pour faire de la France un des leaders mondiaux de l’informatique quantique, a abouti à l’annonce d’un plan national à la fin de l’année 2020.

Une initiative qui profitera à la recherche française. Le rapport propose notamment de créer trois instituts interdisciplinaires en information quantique à Paris, Saclay et Grenoble, dans lesquels chercheurs en physique quantique, en informatique théorique et appliquée, et ingénieurs et industriels des filières technologiques travailleraient main dans la main.

L’Hexagone bénéficie en effet d’un important vivier de chercheurs dans ce secteur et les technologies qui y sont liées. Ces scientifiques sont regroupés à l’Inria, au CEA et dans les laboratoires du CNRS, mais également dans des pôles d’excellence, au sein de l’université Paris-Saclay, et à Grenoble avec le projet Quantum Silicon. Plusieurs d’entre eux sont particulièrement reconnus dans le domaine du quantique, à commencer par Serge Haroche, prix Nobel en 2012, mais aussi Alain Aspect, Philippe Grangier et Jean Dalibard, pour leurs expériences conduites à l’université d’Orsay en 1982 sur l’intrication quantique.

Deux acteurs du quantique sur inovallée : Inria et Probayes

Chez Inria, plusieurs scientifiques sont également déjà reconnus pour leurs recherches dans le domaine : Mazyar Mirrahimi (directeur de recherche et responsable de l’équipe-projet Quantic, à Paris), dont les travaux pionniers en matière de contrôle et de mesure des systèmes quantiques lui ont valu de recevoir le Prix Inria – Académie des sciences du jeune chercheur 2019, Phong Nguyen (directeur de recherche au sein de l’équipe-projet Cascade, à Paris), spécialiste en cryptographie et lauréat d’une bourse ERC Advanced Grant de 2,5 millions d’euros, ou encore María Naya-Plasencia (directrice de recherche au sein de l’équipe-projet Secret, également à Paris), récompensée d’une bourse de l’ERC pour analyser la sécurité des systèmes cryptographiques symétriques dans un univers postquantique.

Sur ce sujet, l’Inria Grenoble Rhône-Alpes travaille sur la création d’une équipe qui sera bilocalisée sur Grenoble et Lyon, autour de deux chercheurs Inria recrutés récemment, Omar Fawzi, directeur de recherche à Lyon et Alastair Abbott, chargé de recherche à Grenoble, ainsi que des chercheurs de l’UGA et de l’ENS Lyon. Le sujet de recherche de l’équipe tournera autour de l’algorithmique quantique, la théorie de l’information quantique et modèles de programmation quantiques.

Le secteur privé n’est pas en reste. Plusieurs entreprises s’investissent dans le domaine, à commencer par Atos, qui lançait en 2016 le programme Atos Quantum pour anticiper le développement de l’informatique quantique.

Inovallée compte un deuxième acteur phare du quantique avec Probayes, qui œuvre sein d’un consortium, dans le cadre d’un programme européen H2020 baptisé COPAC, pour faire avancer la recherche sur le quantique.

L’objectif du projet H2020 COPAC est d’effectuer des calculs sans passer par les qubits, en utilisant le phénomène quantique de superposition. Les niveaux d’énergie peuvent alors être utilisés pour coder les fonctions logiques. COPAC souhaite ainsi démontrer et évaluer une nouvelle approche du calcul, tant sur le plan physique, qu’informatique. L’approche choisie est basée sur l’utilisation de lasers ultrarapides qui viennent exciter un grand nombre de boîtes quantiques par de très courtes impulsions. Cette approche présente un avantage majeur : s’affranchir des problèmes de « décohérence quantique » et donc éviter les nombreuses erreurs de calculs qui y sont liées.